对于不同形状的多台机器人来说,在分布式和无通信的情况下安全高效地避开障碍物是一个挑战。在这种情况下,机器人之间不相互交流,只感知其他机器人的位置和周围的障碍物。大多数现有的多机器人避碰系统要么需要机器人之间的通信,要么需要其他机器人昂贵的运动数据,比如速度、加速度和路径。

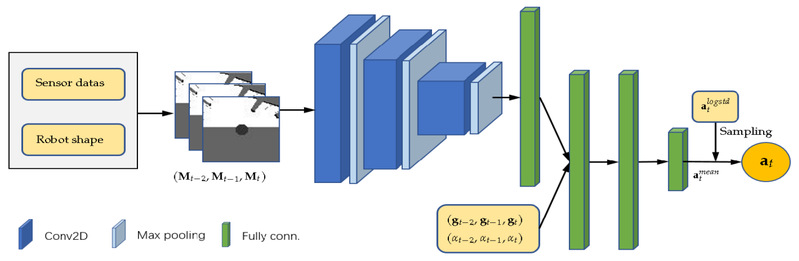

所以我们提出了一种基于地图的深度强化学习方法用于多机器人在分布式和无通信环境下的避碰。我们使用机器人的自中心局部网格图来表示它周围的环境信息,包括它的形状和其他机器人可观察到的外观以及障碍物,这些信息可以通过使用多个传感器或传感器融合很容易生成。然后应用分布式近端策略优化算法(DPPO)训练卷积神经网络,将三帧自中心局部网格图和机器人的相对局部目标位置直接映射到低层机器人控制命令中。

与其他方法相比,基于地图的方法对噪声传感器数据的鲁棒性更强,不需要机器人的运动数据,并考虑相关机器人的大小和形状,使其更高效,更容易部署到真实机器人上。

首先使用DPPO在多移动机器人的指定模拟器中训练如图七所示的神经网络,其中针对多个场景的多阶段课程学习策略被用于提高性能。

图 策略网络的架构

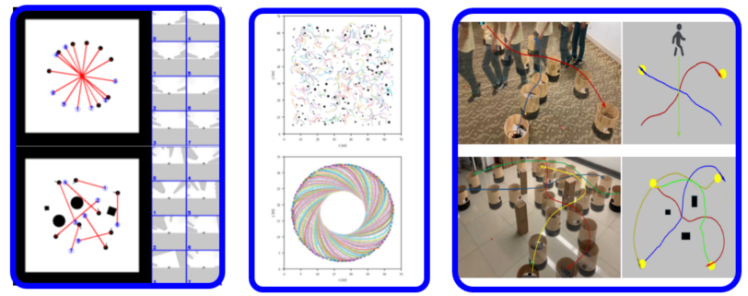

然后将训练好的模型部署到真实的机器人上,在导航过程中执行避碰操作,而无需进行繁琐的参数调整。在仿真器和现实世界中的多个场景下评估了该方法,定性和定量实验都表明,该方法是有效的,且在许多指标上优于现有的基于深度强化学习的方法。

| 该成果已发表在 Sensors2020。 |

图 仿真与实体实验效果图