我们提出了一个群体协同感知系统,其中系统通过自监督视觉里程计进行自身定位,基于元学习进行视觉导航,能够进行单目标和多目标追踪。此外,因为在现实场景中展开实验有一定困难性,因此通过集成仿真和真实数据的强化学习框架对整体实验进行技术支撑。

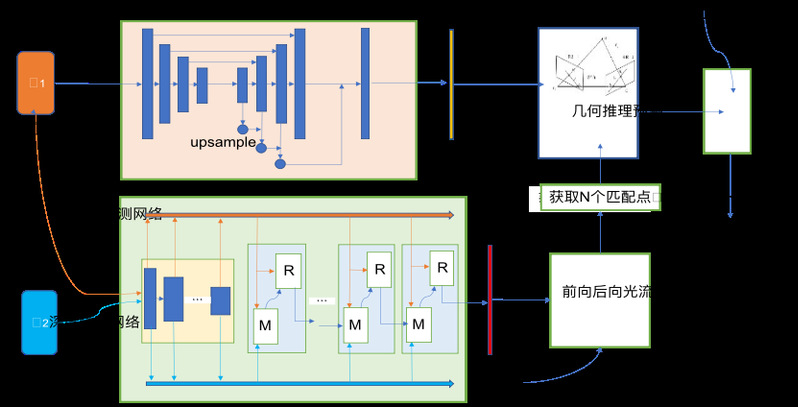

在无人驾驶中,汽车需要实时地获取自身的位置信息,但在一些突发情况,比如网络通信不畅等外界因素的干扰下,基于卫星定位的方式可能无法满足实时位置的刷新。为进一步保证安全性,探索一种不依赖于外界信息而进行实时定位的技术具有重大意义。基于此,我们探索构建了一个仅依靠单目视觉图像序列信息而进行物体实时定位的系统,其融合了单孔相机成像基本原理、光流信息以及图像深度信息,在严格的几何约束条件下充分利用了深度神经网络的拟合泛化能力,初步实现了物体实时位置的刷新。基于该系统,我们正在进行进一步的实验验证和优化,以期取得更高的精确度和响应速度。

近年来,Siam类跟踪器在目标跟踪领域被广泛的研究和应用。然而大部分Siam类跟踪器只能区分目标和无语义信息的背景,当画面中存在干扰物时表现较差,并且无法应对目标移除画面和被遮挡的问题。我们发现,训练数据中的非语义背景和具有语义的干扰物的数据不平衡是学习的主要障碍。为此在训练阶段,我们对现有的检测数据集进行数据增强来提升跟踪器的泛化和判别能力。此外,我们采用从局部到全局的搜索策略来应对因目标暂时消失而导致的跟踪失败问题。目前我们正在设计相关实验进行验证,以对模型做进一步修改,提高模型的表现。

近年来,多目标跟踪发展迅速,各种方法层出不穷,其因在于多目标跟踪在日常生活与军事等领域都能发挥出巨大作用,为了进一步提高多目标跟踪的准确性与实时性,我们提出了一种深度关联网络(DAN),其将帧与帧之间的特征图中的目标通过关联矩阵进行关联计算,从而判断其关联度,减少误判。传统基于检测的多目标跟踪方法未能利用帧与帧之间的关联信息,如果能准确的利用到这些信息必然能够提高跟踪的精度与实时性。而DAN网络可以有效地利用帧与帧之间的关联度,基于该网络,我们正在设计实验对其进行验证,并进行参数调整与优化,进一步提高准确性与实时性。

在三维真实环境中实现对目标物体的导航视觉导航任务需要解决诸多问题,如agent进入新环境后难以快速适应、多个agent在同一环境中执行任务时难以协同完成等。我们提出一种通过元学习方法从标注场景中学习出能适应各种场景的元模型的方法,其在应用于新场景时能够快速适应并导航至目标。在meta-learning阶段在已标注场景中学习到容易迁移至各种场景的策略元模型,在meta-testing阶段将该模型通过强化学习方法快速更新为适应场景的策略模型。更进一步地,考虑多个agent在同一场景中共同完成一项任务,各agent之间相互独立,同时采用分层策略模型,agent之间共享底层子策略模型,不同agent的主策略模型应具有多样性。

深度强化学习为基于视觉的机器人控制提供了一种很有前途的方法。然而,这些模型的推广关键取决于可用于训练的数据的数量和种类。对于某些类型的机器人系统,例如易碎的小型四旋翼机,很难获得这些数据。模拟环境可以提供更大的数据集,但这些数据本质上质量较低。许多使现实世界自主视觉问题具有挑战性的现象,如气流等复杂的物理场景,会产生建模不当或根本没有建模的问题,模拟环境和现实世界之间的系统差异通常是不可能消除的。在这项工作中,我们研究如何将模拟环境和真实世界结合在一个混合的深度强化学习算法中。我们正在尝试使用真实世界的数据来了解复杂的物理场景,并使用模拟数据来学习一个概括的感知系统,该系统能够使机器人仅使用单目摄像机避免碰撞。